ABEJAでResearcherをしている白川です。

8/19-23にロンドンで開催されたKDD 2018に参加してきたので、目についた内容をかいつまんで報告させていただこうと思います。

とくに目についたこと

- 中国系の台頭が目覚ましい。参加者、企業ともに中国系が支配的で、かなりアグレッシブに機械学習・データ分析をビジネスに取り込んでいる印象。

- Graph + Deep Learningが着実に使われ始めている。Deep系の発表でGraph CNNの話をちょくちょく聞いた。

- Finance / Economics の分野に対する注目。

- シェアバイクサービスやAirBnBの部屋貸しサービスような新しいビジネスにおけるデータ分析。

- 新しく使われ始めたテクニックはあまりなさそう。

- 特徴量エンジニアリングをして正攻法で攻めるのはやはり大事。

- NVIDIA, Intel, Twitter, AppleあたりのNIPS/ICMLではよく見る企業のブースがなかった。Googleも小さなブースがひとつだけ。

KDD 2018

KDD(Knowledge Discovery and Data Mining)は応用よりの機械学習/データマイニング系のトップ会議です。 これまでNIPS(2017年参加報告はこちら)やICML(2017年のオーバービューはこちら)のような機械学習系の学会にはちょくちょく参加させていただいていたのですが、KDDは今回が初参加となります。

今回のKDDは8/19-23の間にかけてロンドンで開催されました。会場はExCel Londonという、ロンドン中心部から東に少し行ったところにある非常に大きな展示場でした。 とにかく長い建物で、KDDのセッションが開催されるルームとは反対方面にホテルをとってしまったため、毎朝会場の端から端まで移動するのが大変でした。

(https://en.wikipedia.org/wiki/ExCeL_Londonより)

(https://en.wikipedia.org/wiki/ExCeL_Londonより)

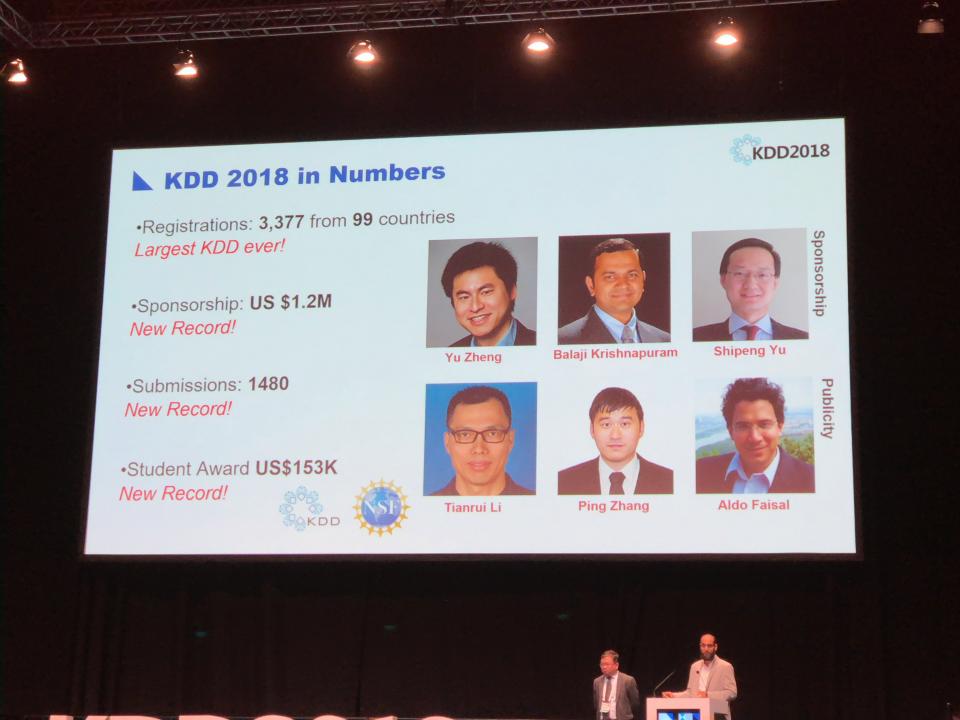

今回のKDDは過去最大の規模だったそうで、99カ国から3377人弱の参加登録があったそうです。会場では日本語が聴こえてくることが結構あって、日本人の参加者は100人近くいらっしゃったのではないでしょうか。

Research Track、Applied Data Science (ADS) Track合わせて1480本の論文が投稿され、Oralが147本(9.9%)、Posterが146本(9.9%)と全体で20%弱の採択率でした。

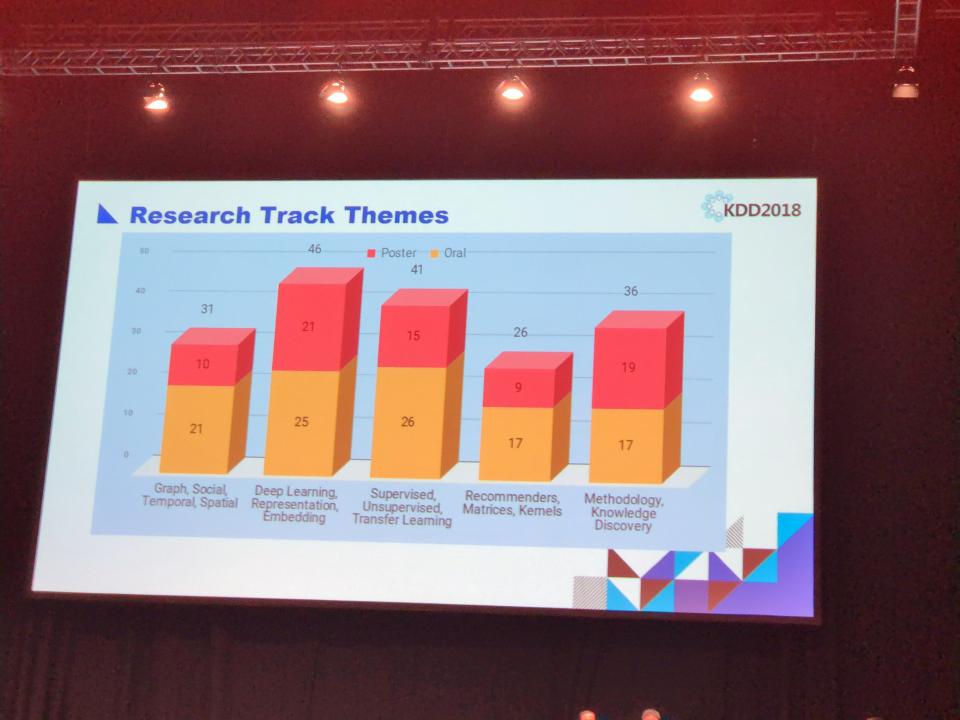

下記の写真は見づらくて恐縮ですが、それぞれのTrackで採択された論文のドメインの内訳です。

グルーピングの仕方がよくわからないですが、Research Trackは採択数が多い方から

- Deep learning, Representation, Embedding 46本 (oral 25, poster 21)

- Supervised, Unsupervised, Transfer Learning 41本(oral 17, poster 9)

- Methodology, Knowledge Discovery 36本(oral 17, poster 19)

- Graph, Social, Temporal, Spatial 31本(oral 21, poster 10)

- Recommenders, Matrices, Kernels 26本(oral 17, poster 9)

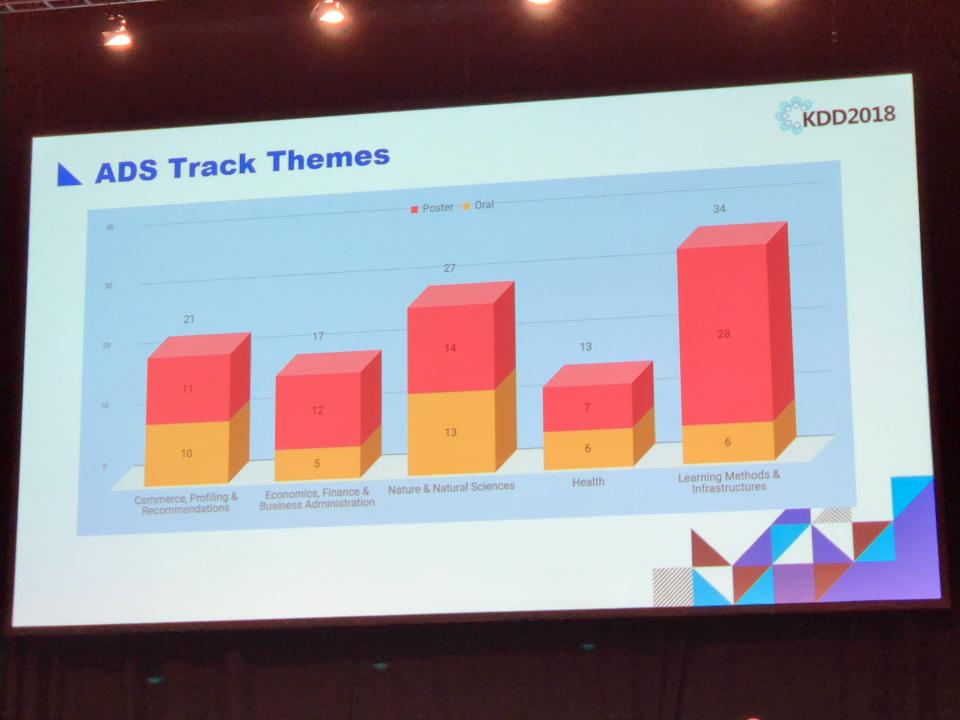

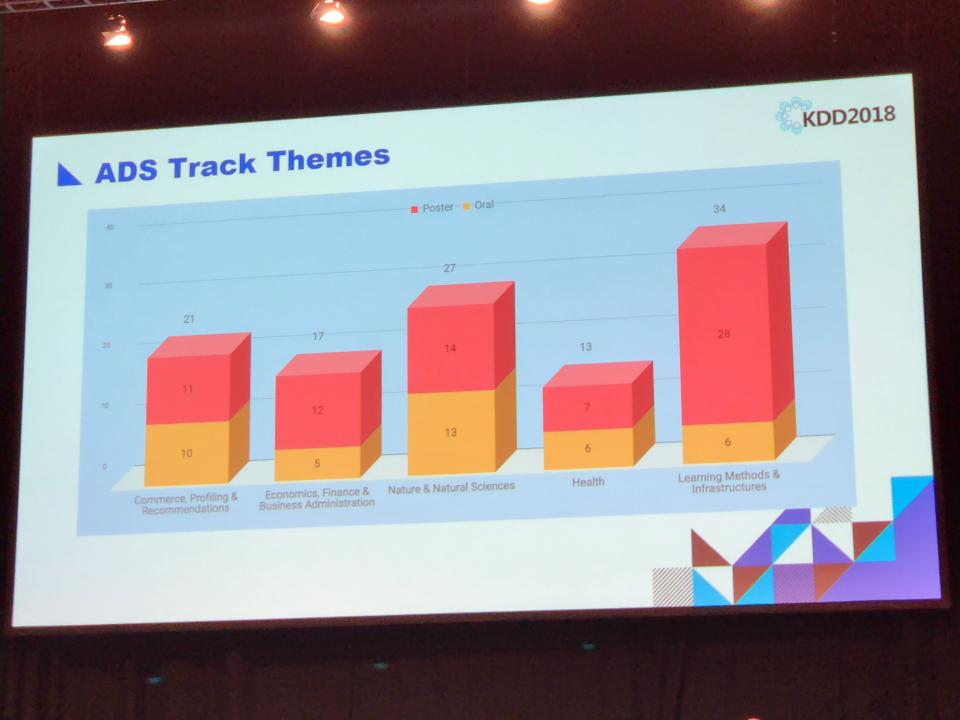

ADS Trackは

- Learning Methods & Infrastructures 34本(oral 6, poster 28)

- Nature & Natural Sciences 27本(oral 13, poster 14)

- Commerce, Profiling & Recommendations 21本(oral 10, poster 11)

- Economics, Finance & Business Administration 17本(oral 5, poster 12)

- Health 13本(oral 6, poster 7)

となっています。やはりDeep LearningはKDDでも流行っているのですね。ADSの方はHealthが5番目だったのが意外でした。

学会はTutorial(1日目)、Workshop(2日目)、本カンファレンス(3,4,5日目)に分かれており、私は全日参加しました。発表の合間合間にKeynote Sessionがあるのですが、

- Data for Good ... Data Scienceをより良い社会を作るために正しく使うべきだとの提言

- Market design and Computerized Marketplaces ... マーケットデザインの理論についての話

- Data Science for Financial Applications ... 金融・経済分野でのデータサイエンスを加速することについての提唱

- On Big Data learning for Small Data Problems ... メタ学習やあ転移学習についての主にDeep Mindの成果についての紹介

という具合で、金融経済系のkeynoteが2本もあったのは、金融都市ロンドンで開催されたからなのか、分野的に注目されているからなのかどうなのでしょう…

その他スケジュールを俯瞰したときに気づくのは、

- Deep Learning Day ... 1日中Deep Learningに関する発表が取扱われるセッション

- Data Science in India / Data Science in China ... なんとインド・中国に特化したセッション

です。Deep Learning Dayについては流行の技術なのでわかるものの、インド・中国に特化したセッションがあるというのは個人的にはびっくりしました。 実際、会場で発表を聞いていると7割くらいは中国系の方な印象で、中国系のData Science分野への進出っぷりは目を見張るものがあります。

参考までに学会の雰囲気がわかる写真を何枚か貼っておきます。

(バンケットの様子。中央のステージではバンド演奏がされていました)

(バンケットの様子。中央のステージではバンド演奏がされていました)

(企業の出展ブースの様子。残念ながら写真を取り忘れてしまったのですが、このブースの奥がPoster Session会場です。学会のセッション終了後は非常に盛況でした。)

(企業の出展ブースの様子。残念ながら写真を取り忘れてしまったのですが、このブースの奥がPoster Session会場です。学会のセッション終了後は非常に盛況でした。)

参加したセッション

以下、私が参加したセッションで目についた発表内容をいくつかピックアップしてお届けします。 ちなみに参加したのは下記のセッションです。

- 1日目(Tutorial)

- Data Science in Retail-as-a-Service

- Crowd-Powered Data Mining

- 2日目(Workshop)

- Common Model Infrastructure

- Deep Learning Day

- 3日目(本会議)

- Deep Learning I

- KDD Cup 2018

- Deep Learning II

- 4日目(本会議)

- Urban Planning

- Data Science Infrastructure

- Semi-supervised and Transfer Learning

- 5日目(本会議)

- Novel APplications

- Knowledge Discovery

Tutorial: Data Science in Retail-as-a-Service

[link]

中国小売大手企業であるJD.COMから、Retail-as-a-Service (RaaS)の考え方とRaaSにおけるデータ分析事例について説明があり、

- 需要予測やレコメンデーションにおけるDeep Learningの精度面での有効性

- 在庫管理や物品の配置、顧客への配送を最適化するソリューション

- 先進的な小売を展開する7Fresh

が紹介されました。購買から配送までのすべてを一手に担い、大規模多角的に先進的な技術をどんどん社会実装していく姿勢は非常に 刺激的で、ぜひ見習いたいと思いました。 詳細は先のリンク先で公開されている下記スライドに記載をご覧ください。

www.slideshare.net

Tutorial: Crowd-Powered Data Mining

[link]

本チュートリアルではAmazon Mechanical Turkなどの品質保証の難しいクラウドソーシングサービスにおいて、

- ワーカーやアノテーション結果の品質推定をどう行うか

- クラウドソーシングで得たデータにたいするデータマイニング・機械学習の適用方法

についてかなりひろく徹底的にサーベイが行われました。

要するに、クラウドソーシングの結果はノイジーで不正確という前提のもとで、どのようにデータマイニングや機械学習をすればよいかという話でしたが、 ワーカーの品質推定、UIの工夫、ノイズ自体のモデリング等々、とても参考になる内容でした。 スライドはかなり分量が多い(234ページ!)のですが、とてもよいイントロダクションになっているのでオススメです。

なお、ワーカーの品質推定については、以前書かせていただいた下記の記事の最後の方でもご説明させていただいているので、 ご興味がある方はこちらも合わせてご覧ください。 tech-blog.abeja.asia

Deep Learning Day

[link]

Deep Learningにフォーカスしたセッションです。ICMLやNIPSだとこういうセッションにへばりつくこともあるのですが、今回はあえて他のセッションに参加してみようと考えていたため、本セッションの最後の後半部分しか参加していないのですが、Graph Neural Network の話が立て続けに出てきて、ちょっとびっくりしました。伝統的にKDDではグラフが扱われることが多い印象ですので、当然の流れかもしれませんが、いま数えてみたところ、採択された32本のうち、Graphに関する論文が7本あって、ちょっとうれしくなりました。去年辺りから飛び道具というより、普通の道具として研究・応用されている感が出てきており、とってもいい感じです。

Graph Neural Network(というかGraph CNN)にご興味があれば、ちょっと古くなってきてしまいましたが、こちらの記事を参照してください。

KDD Cup

KDDに来たからにはKDD Cupのセッションにも出てみようと思い参加しました。今回のKDD Cupのタスクは北京とロンドンにおける48時間後までのPM2.5等の汚染物質の分布予測だったそうです。過去の気象データと汚染物質の分布データ、および将来の気象予報データなどが入力として与えられます。 1-6位のチームの手法が報告され、個別の細かい工夫を除くとおよそ下記の感じだったようです(GBRT, GBDTなど記述がぶれていますが、いずれもGradient Boosting Treeで、発表者の記法を尊重しています)。

- 1位 ... かなり綿密なFeature Engineeringをし、GBRT

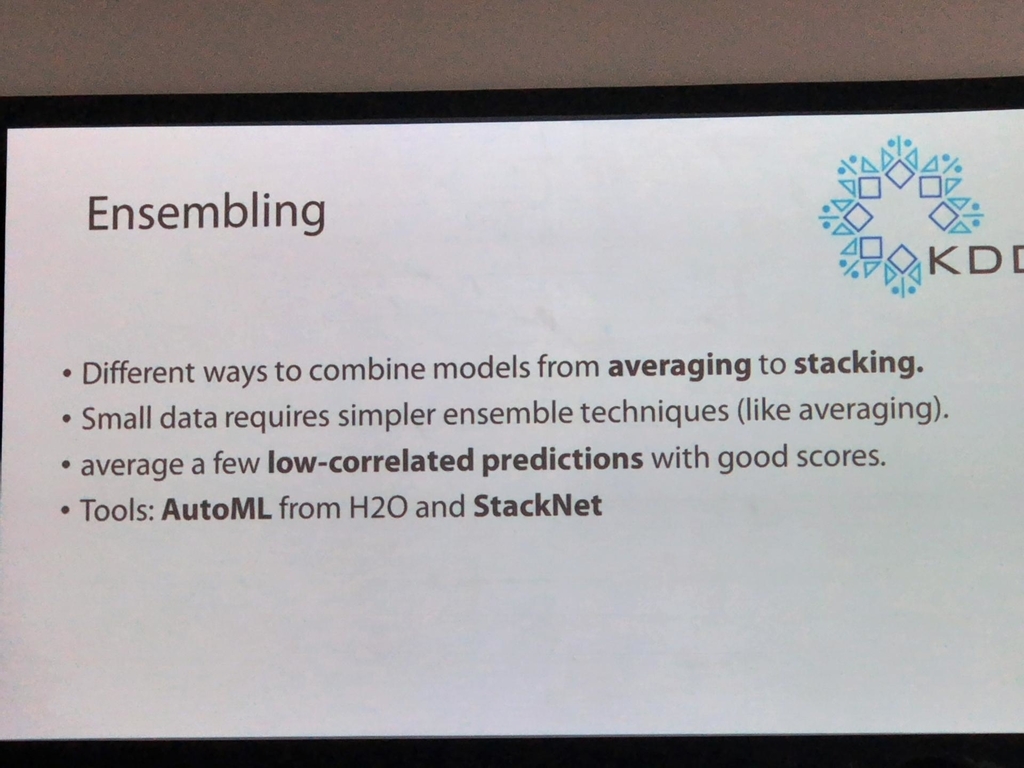

- 2位 ... Feature Engineeringをし、GBDT, DNN, RNNのアンサンブル+スタッキング

- 3位 ... 欠損値補完をしつつFeature Engineeringをし、XGBoost, ExtraTreeRegression, LightGBMのモデルをアンサンブル

- 4位 ... ひたすらFeature EngineeringをしてLightGBMに投入しただけ (LightGBMを使っただけなので、モデルについて特に言うことはないとおっしゃってました笑)

- 5位 ... Feature EngineeringしてLSTMでフィッティング

- 6位 ... Feature EngineeringしてSeq2seqでフィッティング

いずれも、ドメイン知識を使いながらFeature Engineeringをひたすら頑張り、DNN, GBTへ投入して必要ならアンサンブル/スタッキングするという、お手本のような手法でした。

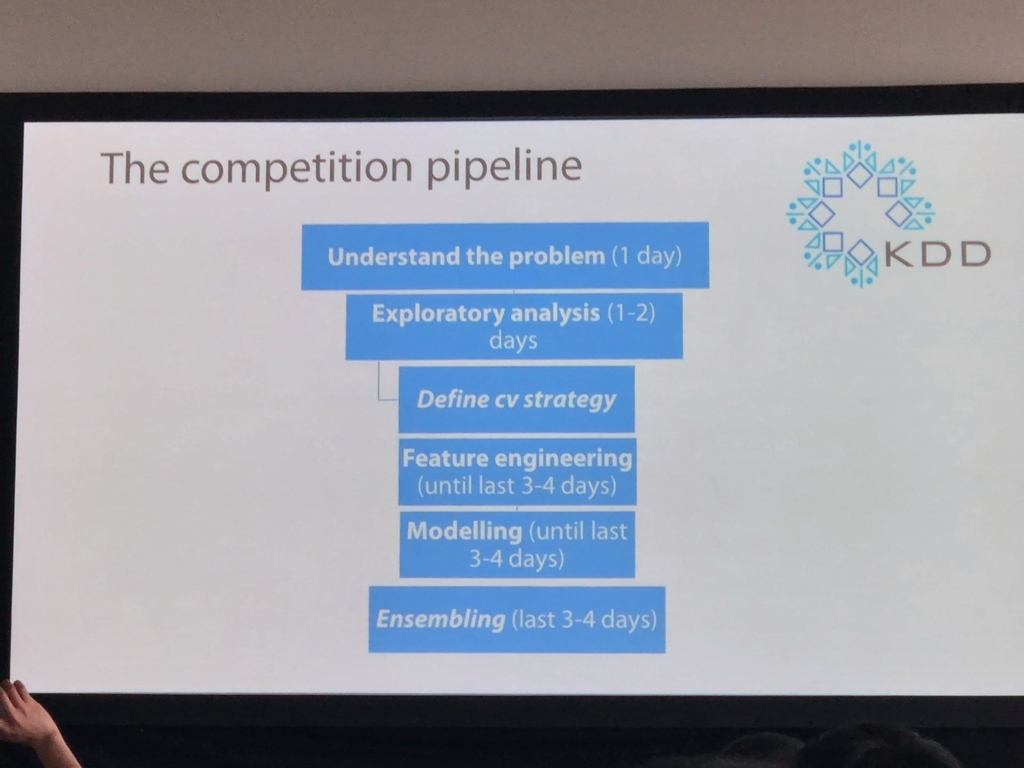

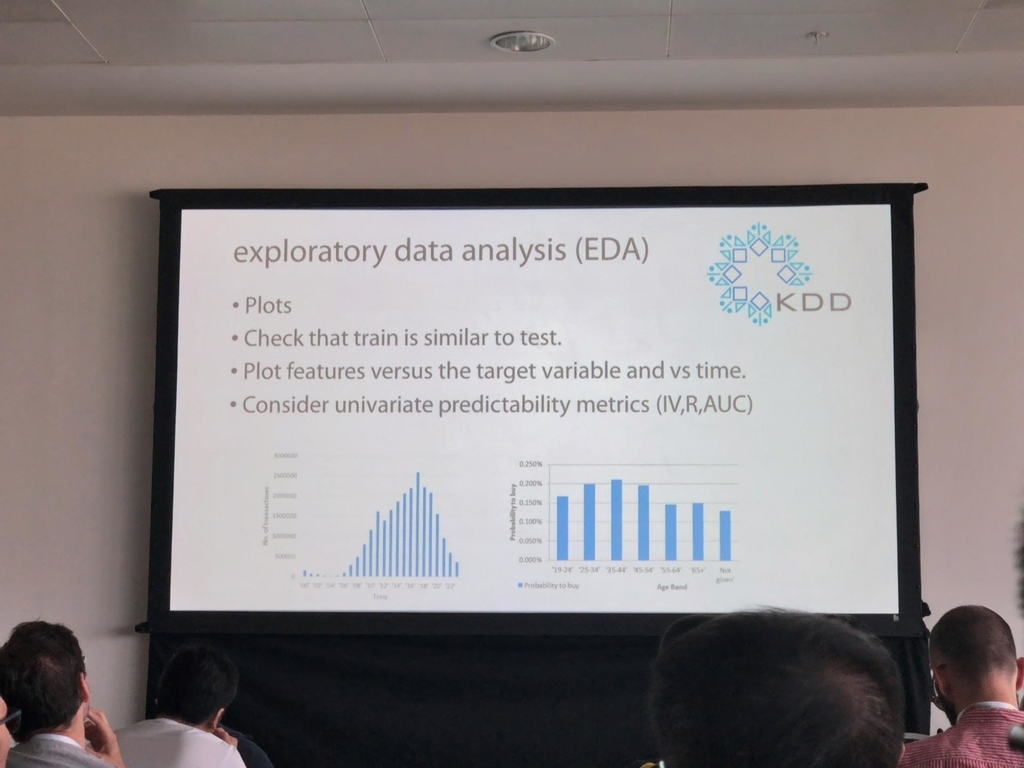

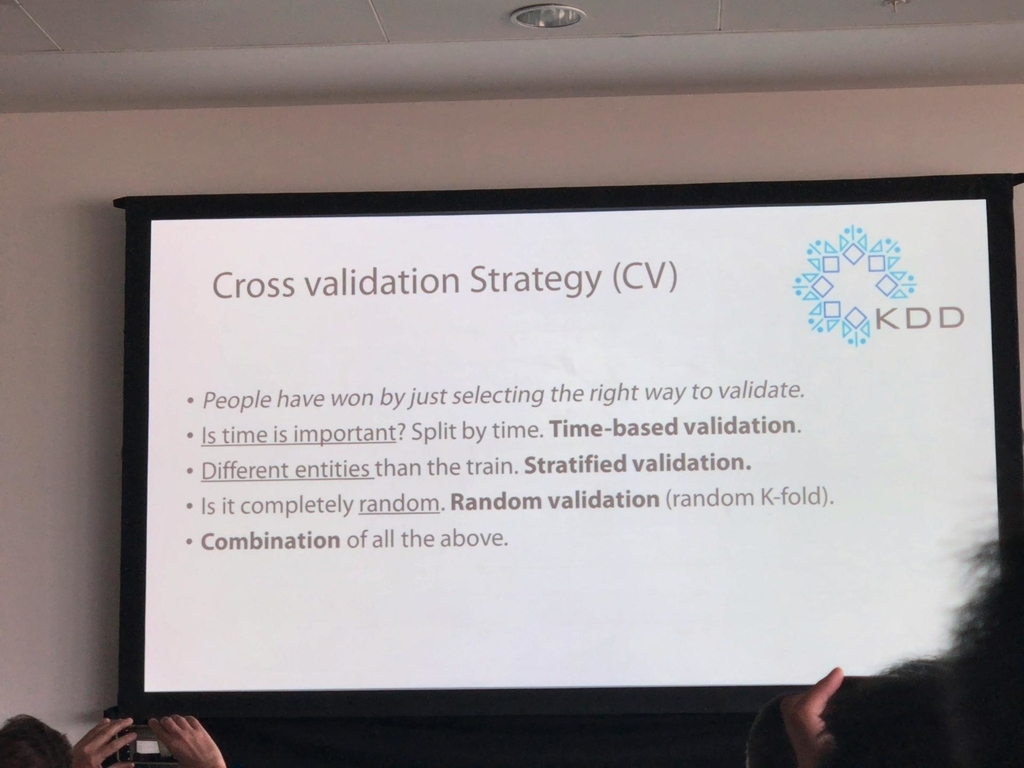

上位チームの発表のほか、keynote speachといて、Marios Michailidisさん(KaggleではkazAnovaという名前で知られているトップランカー)による自身のデータ分析プロセスの紹介がありました。 非常に実践的で、データ分析の各ステップでの注意点やオススメの方法などいろいろと教えていただきました。スライドが手に入ればよかったのですが、私のぼやけた写真でご容赦いただくことにすると、下記のような具合でした。

こちらも、特に特別なものはなく、必要なものを正攻法的に着実に実装していくのがやはり大事なのだなと思いました。

Urban Planning

本カンファレンスのセッションの一つで、どんな内容が発表されるのだろうと興味を持ったので参加してみました。発表内容は

で、新しいビジネスモデルが生まれると新しいデータ分析も生まれるのだなと感じました。

Software 2.0 & Snorkel

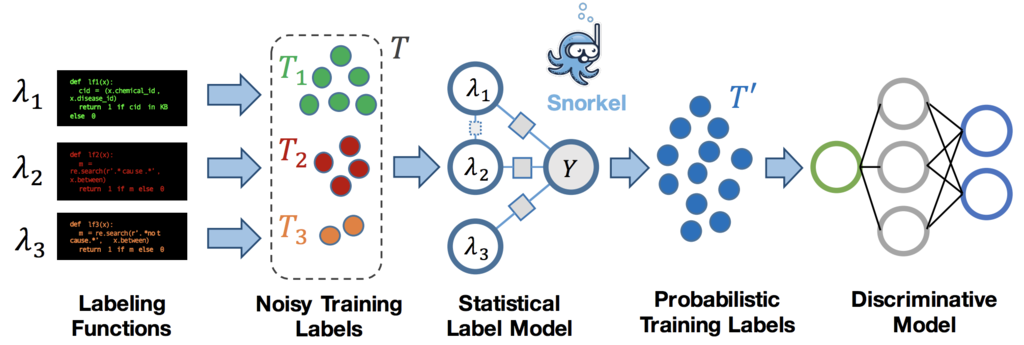

Snorkelは2016年のNIPSで発表されたData Programmingという考え方が実装されたシステムで、アノテーションの代わりにLabeling Functionと呼ばれる、 例えばルールベースのような不完全なラベル付け関数をユーザーに複数定義させ、その出力を確率モデルで統合することによりラベルを推定し、その推定されたラベルをつかって予測モデルを構築します。

("Software 2.0 and Snorkel: Beyond Hand-Labeled Data"より引用)

("Software 2.0 and Snorkel: Beyond Hand-Labeled Data"より引用)

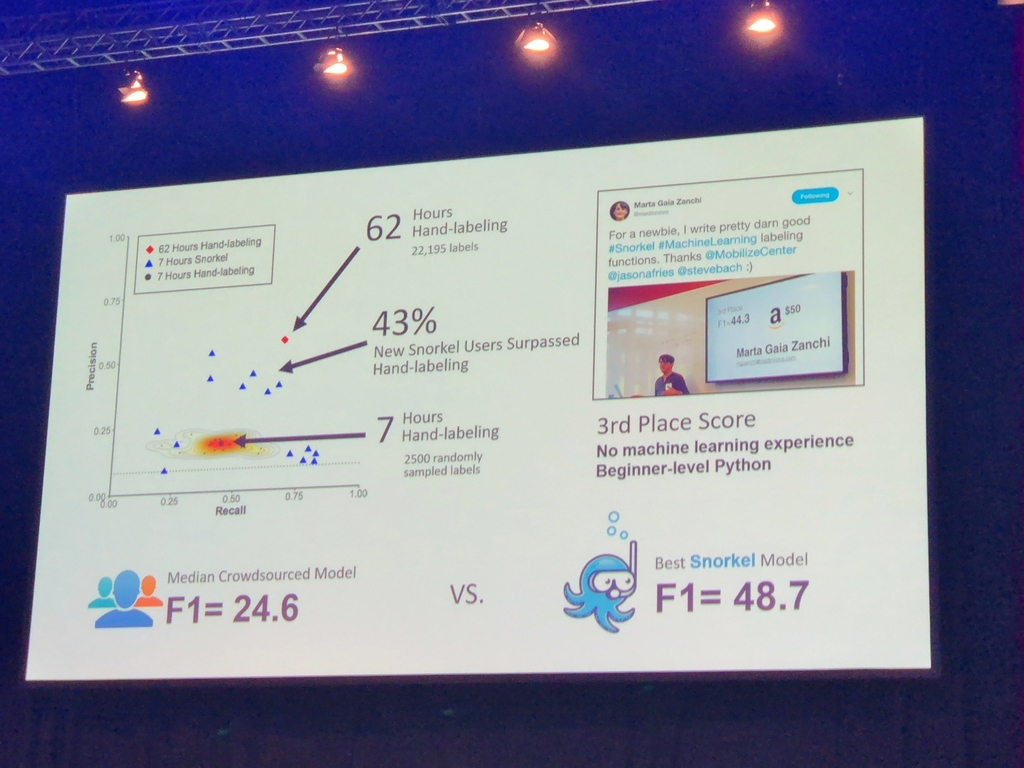

考え方が斬新なのでNIPSで発表された当時から面白いなとは思いつつ、間接的にタスクを解きに行くタイプの方法なので、実際のところどれくらい有効なのだろうとチラ見していた程度だったのですが、

ある実験においては、手動でのラベリングよりSnorkelのほうが効率的だったそうです。

Snorkelの考え方を発展させたシステムが他にも複数開発されているそうで、下記のページに行くと情報がまとまっています。

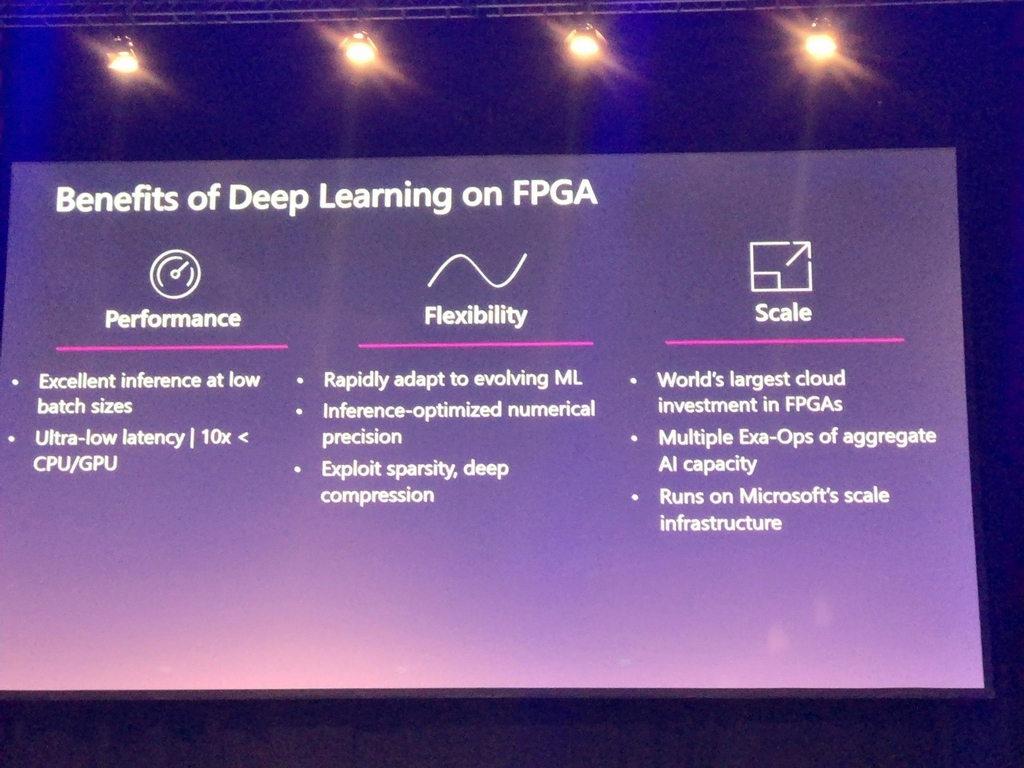

Novel Applications: Planet-Scale Land Cover Classification with FPGAs

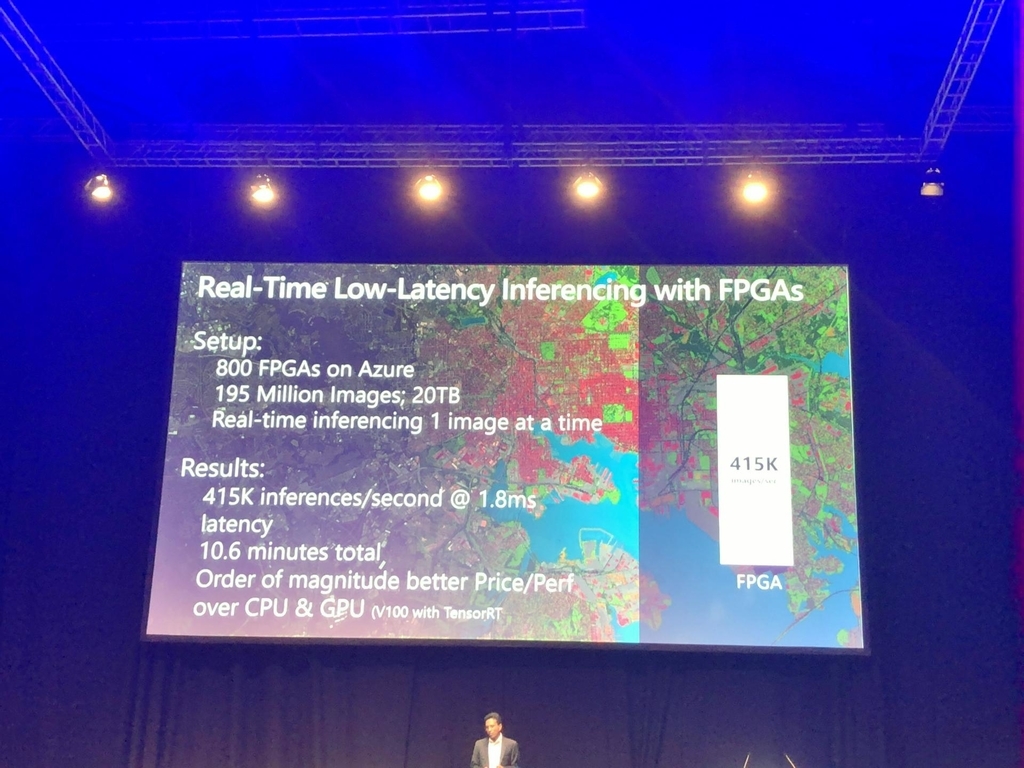

Microsoftからの発表で、衛星からとった地表の写真を地球規模でセグメンテーションしていくプロジェクトにFGPAを活用する話でした。 プロジェクト自体の規模の大きさについてもさすがMicrosoftと思いましたが、それ以上にFPGAの高速さに非常に感心させられました。

動画や写真を撮ってあればよかったのですが、残念ながら撮りそびれてしまったので文章でお伝えすることになってしまいますが、 CPU,GPU、FPGAにセグメンテーションをするDeep Neural Networkを実装し、ヨーイドンで実行速度の比較をしている動画があり、その動画では圧倒的にFPGAが速く(GPUより10倍くらいは速そうでした)、 これは苦労してでもFPGAに実装する意味はあるなぁと思いました。発表を聞きながら、社内のFPGAに詳しい人達に「FPGA入門の仕方教えて」とリアルタイムで聞いてしまうくらいFPGAの効率性は印象に残りました。

ちなみに下記が上記セグメンテーションプロジェクトの構成と結果です。20TBも画像があればGPUでもやってられないですね。

195M枚で20TBということは、画像1枚あたり100KBくらいなので、そんなに大きくない(かといって小さくもない)画像かもしれないですが、415K枚/secは圧倒的です。

さいごに

KDDは初参加でしたが、世の中で技術がどう使われているのか、どんなデータ分析がされているのかがちょっとわかった気がして、非常に楽しかったです(ロンドンも最高でした!)。一方で、技術的なトレンドがあったのかなかったのか、いまいちわからなかったのが個人的にはどういうことなのかちょっと気になっていますが、Deep Learning含め、技術がかなり成熟してきて、技術一本で殴るというより職人技、合わせ技で着実に攻め倒すというような感じになってきたということでしょうか。

今後もKDDの動向はチェックしていきたいと思います(ちなみに来年はアラスカのアンカレッジで開催されるそうです)。

宣伝

ABEJAではイケててヤバい方、技術動向に敏感な方、社会をより良くするために技術/ビジネス実装をしていきたい方を探しています。 www.wantedly.com

ABEJAが発信する最新テクノロジーに興味がある方は、是非ともブログの読者に!

ABEJAという会社に興味が湧いてきた方はWantedlyで会社、事業、人の情報を発信しているので、是非ともフォローを!! www.wantedly.com

ABEJAの中の人と話ししたい!オフィス見学してみたいも随時受け付けておりますので、気軽にポチッとどうぞ↓↓