1, はじめに

こんにちは, Researcher Intern の中野です.

新型コロナウイルスが世界中で猛威をふるい、個人の生活スタイルのみならず社会全体に変革が迫られているのを感じます。

医療従事者の方々には頭が上がりませんが, 機械学習のコミュニティでもKaggleのコンペ, SIGNATEのコンペ等, なんとか状況の改善に貢献しようという動きが見られます.

このような直近の例にも見られるように, 機械学習はデータを扱うあらゆる分野での応用が考えられます.

自分も, 大学での専攻は物質プロセス工学(材料工学系)なのですが, 材料工学に機械学習を応用するマテリアルズインフォマティクスという分野での研究を行っています. 軽く内容を紹介させていただくと, 研究では新素材の製造プロセスを, ガウス過程回帰に基づいたActive Learning アプローチを用いて, 低コストかつ高速に最適化するタスクに取り組んでいます.

このバックグラウンドと機械学習実務に近いABEJAの知見から, 今回の記事では, 画像データに対する Active Learningの現状と展望を, いま注目の教師なし学習手法の解説を添えて, お届けします.

* この記事で取り上げている事 *

- 機械学習におけるActive Learning の大まかな思想

- Active learning の, 近年の研究動向ダイジェスト

- 上記を踏まえた, いまHotな教師なし事前学習手法に関する解説

- 画像データに対する, Active learning の使い所の提案

2, 画像データでの Active Learning

2.1, 画像へのアノテーションとActive Learning

画像データに機械学習を適応しようと思った時, 避けて通れないのが, 「アノテーション」です.

例えば, よくある「いぬとねこを判別する画像分類のモデル」を学習させるための, 教師データの作成におけるアノテーションでは,

以下のような画像が与えられた時,

画像に対して「犬」と意味づけ(アノテーション)をし,

以下の画像には,

「ねこ」と意味づけをします.

アノテーション作業とは, このような単純作業を数千〜数百万枚の画像に対して行う作業であり, いぬとねこが最高にかわいいのを加味しても, 精神的に結構しんどいプロセスです.

しかも, 作りたい機械学習モデルによっては, もっと悪夢のような作業も考えられます.

例えば, 以下の例,

は「高速道路下の交差点付近」の画像に対して,

- 領域ごとのピクセル単位での塗り分け

- 塗り分けた領域ごとの意味づけ

というアノテーションを行った後の画像です.

いぬとねこの例と比較にならないくらい作業が複雑になっているのが伝わりますでしょうか. いぬとねこに比べて, かわいくもありませんね.

このように, アノテーションはしんどい(= コストのかかる)作業である為, 機械学習モデルを訓練する為の教師データを作成する際, 大量の画像データの全てに対してアノテーションをするのではなく, 「モデルの学習に効果的な画像」を優先してアノテーションする事で, アノテーションの総量を少なく抑えて教師データの作成ができたらハッピーです.

これを実現しようとする取り組みが, 機械学習の文脈での(いまの例だと画像系のタスクでの)Active Learning(能動学習)というアプローチです.

2.2, Active Learning

先ほど述べたとおり Active Learning は, 限られたコストの下で効率よくデータセットを作成することを目指すアプローチです.

細かい理論まで深堀するとブラジルまで掘れてしまいますので, 詳しい解説は優秀な日本語の文献の数々([1], [2], [3] )にお任せし, ざっくりとした概要の解説をします.

2.2.1, 大まかな種類の分類

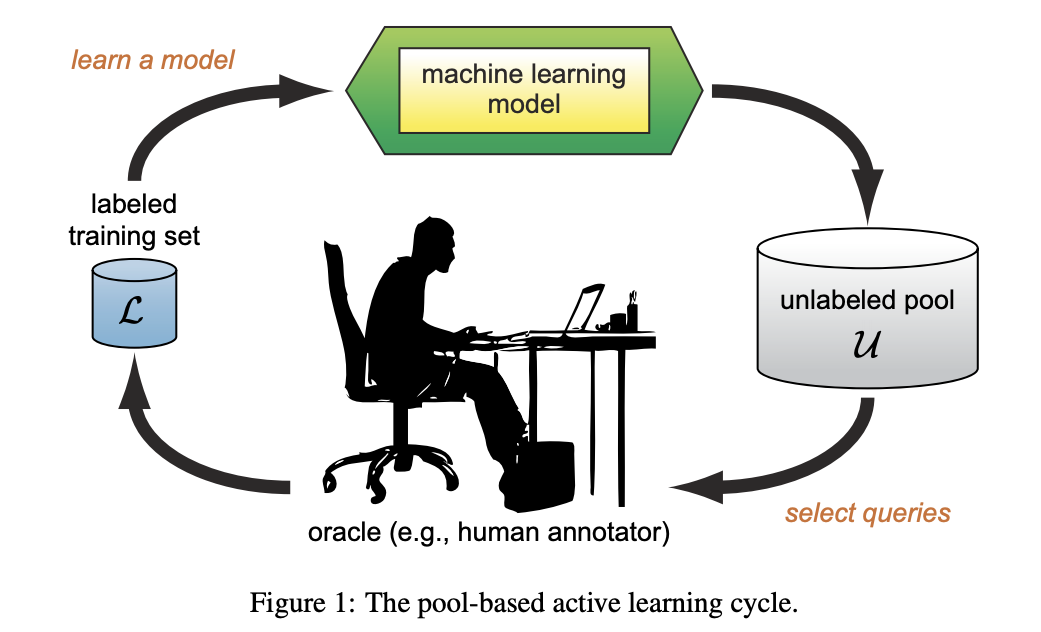

Active Learning アプローチの種類として, まだラベル付けがされていないデータをどう扱うアプローチかで, 以下のように3つにカテゴリ分けができます. (settles, 2009に準拠. 文献によって分け方が異なる場合も)

- membership query synthesis:モデルの学習に有効なデータを生成するアプローチ.

- stream-based selective sampling:データに対してラベル付けするか破棄するかのふるい分けを行うアプローチ(ふるい分けは一度である事が多いので「stream」)

- pool-based sampling:ラベル無しデータのプールから, モデルを学習させる上で最も効果が高いと考えられるデータを選択するアプローチ.

上記の3つの中ではpool-based sampling手法が最も一般的です.

また, その pool-based sampling 手法の中でも, 未ラベルのデータをどのような基準で選択していくのかで, 複数のアプローチがあります. メジャーなのは, 不確実性サンプリング(Uncertainty Sampling )と呼ばれる, モデルで推論を行う際に推論結果の不確実性が最も高いデータから優先してラベル付けをしていくアプローチです.

これは例えばテスト対策で, 「今まで何回も解いたことあって, 解法を完全に覚えている問題」よりも「まだ見たことのない種類の問題」の対策をした方が成績アップが望めるのと同じ理屈です.

2.2.2, よく挙げられる問題点

よく挙げられる問題点としては,

- サンプリングバイアス;データが少量の初期段階では, サンプリングしたデータの偏りによって, Active Learning の提案にも偏りが生まれてしまう. (ある程度の初期データが必要. )

- アルゴリズム依存;Active Learningで得られるデータは, その時点でのモデルに強く依存しているため, 途中でモデルを変更した場合, 今までに取得したデータはそのモデルにとって最適でない場合がある.

- 費用対効果;Active Learning を考えるよりも, 安い人件費でさっさとアノテーションを外注した方が, コスパが良い場合がある. (ただし一般的に, 人件費が安い ≒ アノテーションの質が低い → モデルの精度が上がりにくい)

があります.

小まとめ

- 機械学習の文脈における Active Learning は, 正解データを作成する作業を効率よく行いたいという欲求を, 正解データ作成途中でのモデルからの情報を用いて達成しようという, 実務での問題意識ベースのモデル構築のアプローチ.

- いくつか課題も考えられる.

ここまでが, 大まかな Active Learning に関する解説です.

次は, Active Learning の最近の研究動向について, 論文ベースで解説していきます.

3, Active Learning の研究動向

3.1, 次々と新しい手法が提案されている

アルゴリズムに様々なテクニックを使用し, 「限られたアノテーションデータでのモデルの精度を競う」ような風潮があります. ここでは近年提案された中でも, 比較的注目度の高い手法をザッと見ていきます.

個々の具体的な実験結果に関しては, 本記事では触れませんので, もしご興味あれば元の論文をご確認ください. また, 紹介の順番に意味はありません.

Variational Adversarial Active Learning(Sinha et al., 2019, ICCV)

VAE(Variational Auto Encoder)は, 画像表現を正規分布のパラメータへ埋め込む事で画像の特徴を獲得する手法です.

全量データに対して構成されたVAEと、それにより画像をencodeして得た低次元表現がラベル付きデータに由来するものかどうかを判定する判定機とを敵対的に学習することにより、ラベル付けの必要なデータを効率的に抽出する方法。抽出された画像にたいしては任意のOracleで実際にアノテーションする対象を決定します。

敵対的な学習により, 暗黙に, モデルがまだ得ていない特徴をもつ未ラベルのデータを効率よくサンプリングできます.

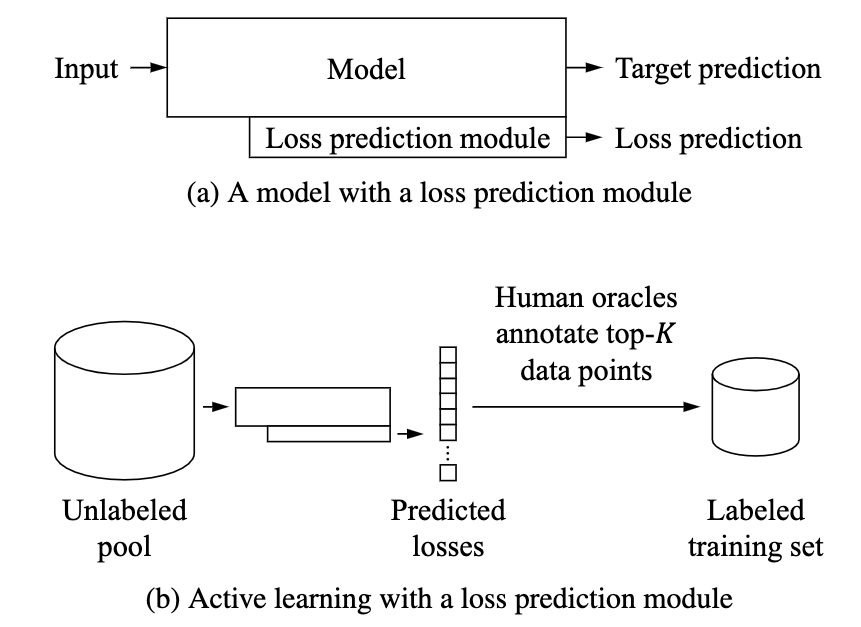

Learning Loss for Active Learning(Yoo et al., 2019, CVPR)

未ラベルの画像データの損失関数(loss)を直接予測する事で, 使用するモデルに依存せず, かつ計算効率の高い Acvtive Learning 手法です.

この論文の詳細に関しては, 以前ABEJAの緒方さんがまとめてくださっています. https://www.slideshare.net/takanoriogata1121/cvpr2019cv

Deep Bayesian active learning with image data(Yarin Gal et al., 2017, ICML)

https://dl.acm.org/doi/10.5555/3305381.3305504

Deep Bayesian Neural Network (通常のNNでの出力に加え, 出力の不確かさも得る)をモデルとして用い, 相互情報量を最大化するデータを次にラベル付けするデータとして指定する手法です.

多くのActive Learningでは次にアノテーションすべきデータを定量化するためのacquisition functionが多数提案されているが, 本論文ではそれらの一部を変分近似により推定された事後分布を用いることで効率的に近似する手法が提案されています.

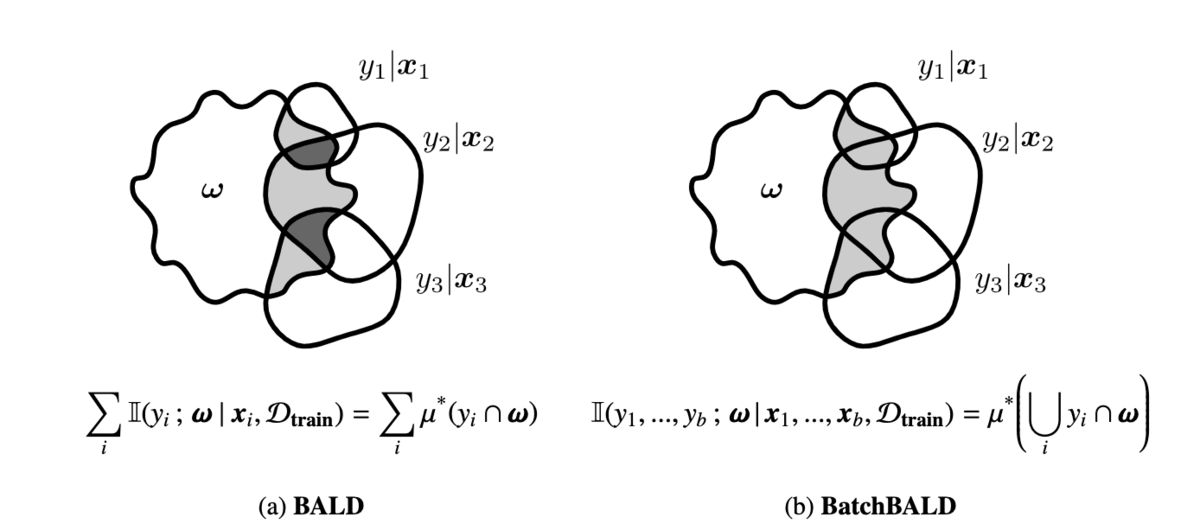

BatchBALD: Efficient and Diverse Batch Acquisition for Deep Bayesian Active Learning (Andreas Kirsch et al., 2019, NeurIPS)

上記の [Deep Bayesian active learning with image data(2017, ICML)] の手法をさらに, 有益なバッチの取り方に関して工夫したもの.

前述の手法でも扱われていたacquisition functionの一つであるBALD(Bayesian Active Learning by Disagreement)を複数データ(Batch)の提案に拡張した指標を提案されています.

この指標のsubmodular性に着目し, 効率的な貪欲解法を採用することにより, 冗長性の少ない複数のアノテーション候補を一度に提案することを可能としています.

この手法は, 各データを観測する事で得られる情報の重複性などの相互関係を加味することが, 効率よくバッチ単位でデータを取得するには重要だという直感に基づいています.

Bayesian Generative Active Deep Learning(Tran et al., 2019, ICML)

https://arxiv.org/abs/1904.11643

BALDによって選択された候補データに対して, VAE-ACGAN(auxiliary-classifier generative adversarial networks )によってBayesian Data Augmentation (BDA)を適用することで, 学習の効率化をはかった手法です.

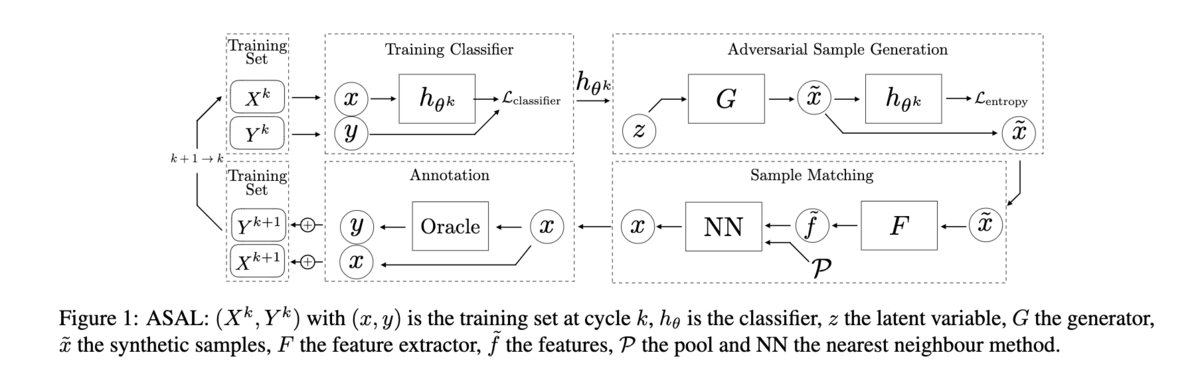

Adversarial Sampling for Active Learning(Mayer et al., 2020, WACV)

学習されたclassifierのエントロピーが大きくなるようなサンプルをGANによって生成し, それに最も類似するデータを探索する方法が提案されています.

Discussion のセクションで, 優れた性能を示す場合と, ランダムサンプリングより性能が良いことを証明しにくい場合がある事について議論されています.

小まとめ

比較的最近の論文を読んでいると, 近年はActive Learning とAdversarial Training の組み合わせがHotなのかなと感じられました. (ただ, ここで紹介した論文は一部であり, 他にも無数に手法が提案されています.

どれも様々な工夫が為されており, 読んでいて非常に楽しいです.

しかし, そういった手法を眺めながら冷静に大元の目的を考えると, これらの手法は,

- ラベル付けしたいデータを提案させるためのモデルの学習に必要なアノテーション済のデータ量がかなり多そう( Active Learning の意義とは?)

- モデルの学習に非常に時間がかかりそう(素直にアノテーションした方が早いのでは?)

といった, ホントに実務で使えるの?という観点の疑問も浮かんできます.

そして近年, そうした 「現状の画像データに対するActive Learning研究の方向性に疑問を投げかける」ような風潮も出てきています.

3.2, 近年の Active Learning の研究結果を, 疑問視する風潮

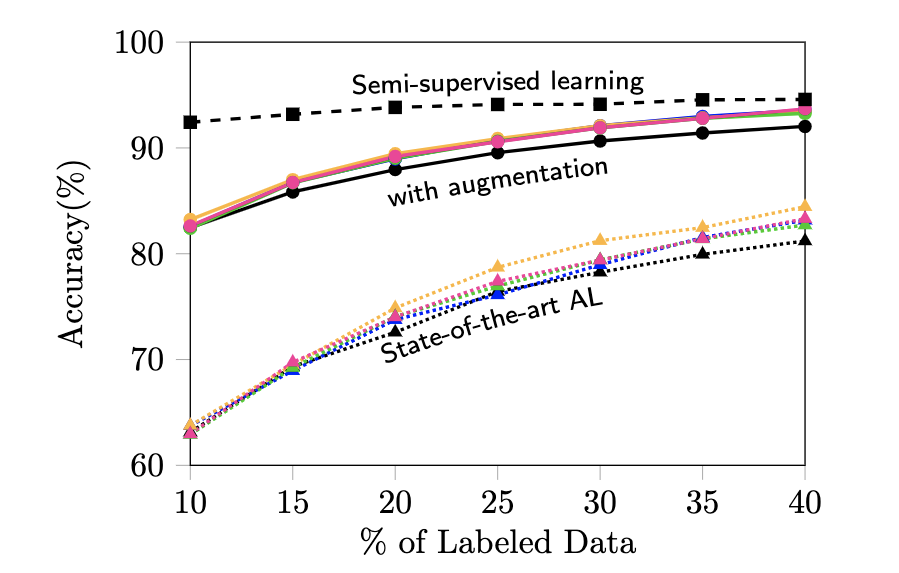

Parting with illusions about Deep Active Learning(Mittal et al., 2019, arXiv)

https://arxiv.org/abs/1912.05361

- 近年のActive Learningの研究成果は, 検証が不十分で, Data Augmentation を行わずに主張されている Active Learning の精度改善は, 簡単な Data Augmentation の導入によって改善する度合いと比較して, 無視できるほどに小さかったりする.

- 半教師あり学習・教師なし学習は, Active Learning と似たような問題設定から発展しているアプローチであるが, それらの手法との比較が十分になされていない. (自分がサーベイをしていても, トップカンファレンスに通っている論文であってもこの傾向が見られた. )

- 上記2点を考慮した場合, Active Learning 間の精度競争が無視できるほどに影響が小さいモノである場合がある(下図).

- アクティブラーニングを開始するために必要とされている「最低限」のデータが大量すぎる.

Rethinking deep active learning- Using unlabeled data at model training(Siméoni et al., 2019, arXiv)

https://arxiv.org/abs/1911.08177

- Active Learning は, 半教師あり学習と両立させる事でより効果が出る, という事を示した論文.

- これからの Deep active learning は, アノテーションにかけられる予算・モデルの学習サイクル・教師なし事前学習, 半教師あり学習と密接に関連する. (なので, これらとの比較が必要. )

小まとめ

画像データのアノテーションに関する Active Learning の研究は, 次々と新手法が提案されている一方で, 実用性の低さや検証不足を指摘し始められている風潮がみられます.

実は, Active Learning 自体はマテリアルズインフォマティクスの分野(自分の専攻)でも使われていて, その際は, 非常にコストの高い物理実験を最適化する際に, 「次にどの値で実験を行えば良いかの提案をする」というアプローチで用いられたりします.

しかし, 画像データに対して使用する場合は, 物理実験に使用する場合と状況が異なり, ラベル付されていなくても, 画像データが存在するというのが大きなポイントだと思います.

すでに画像が存在しているということは, そこから何かしらの表現を学習することができれば, そもそもアノテーションをする以前にモデル精度の向上を図ることが可能です. なので, Active Learning のモチベーションである「アノテーションを効率的に行いたい」を実現するためには, 教師なし学習・半教師あり学習手法を用いた上での Active Learning 精度検証を行うべきだと考えます.

そもそも Active Learning は, そういった事前学習手法と両立してこそ真価が発揮されるのではないかと考えています(後述).

そこで次は, 教師なし事前学習の手法として有力視されている最近の研究に関して解説します.

4, 画像データに対する教師なし学習

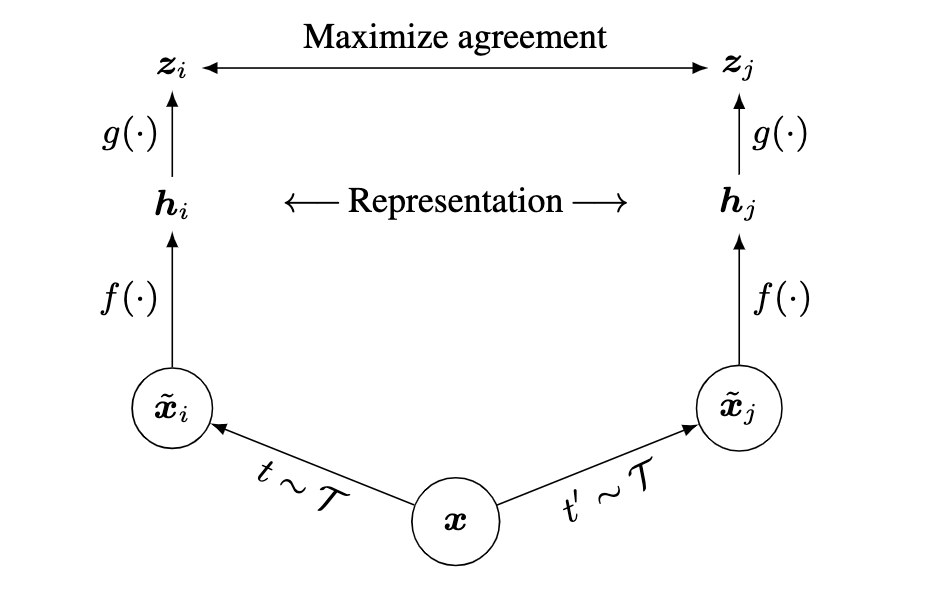

Contrastive Learning

画像データに対する教師なし学習の目的は, 画像へのラベル付けを行う前の段階で, 画像ごとにタスクを解く為に有効な特徴をモデルに事前学習させることです.

Contrastive learning では, データに適宜Augmentationなどを施しつつ他のデータとの対比(pretext taskなどとよばれる固有のタスクが定義されます)を通じた教師なし学習をすることでこの目的を達成します.

イメージとしては,

以下の画像を(インターン中に撮影した東京タワー),

それを加工した以下の画像と,

同じ画像をまた別の方法で加工した以下の画像が,

「同じ画像を加工したペアである」という事を, この東京タワーを含めたN個の元画像から, 同じくこの東京タワーのように2通りに加工して生成された2N個に関して, モデルに学習させる.

といった感覚です.

タスクやデータによっては, ラベルなしにも関わらず教師あり学習に匹敵するような表現の学習ができる, いま注目の学習アプローチです.

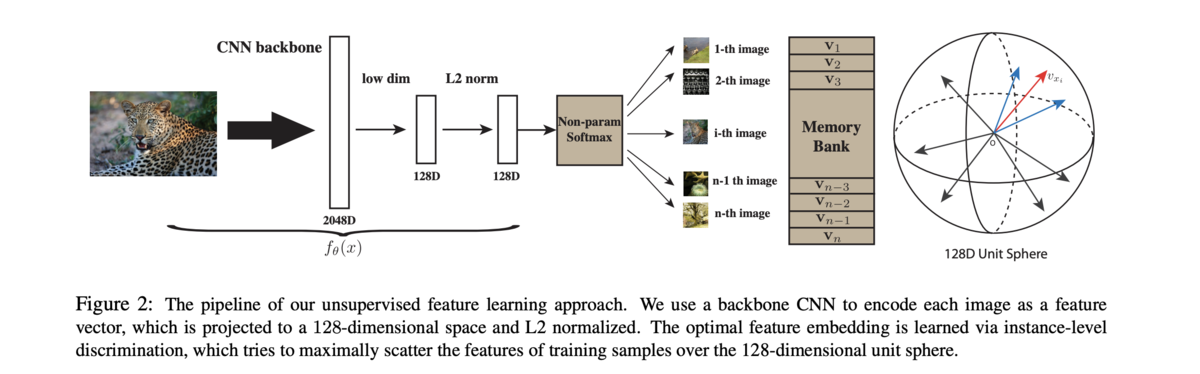

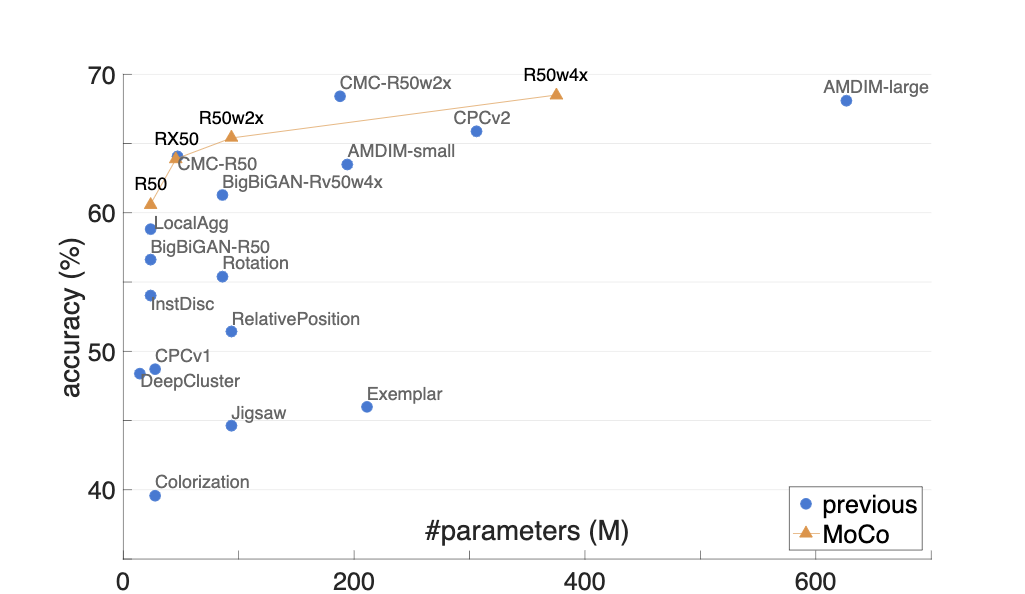

Momentum Contrast for Unsupervised Visual Representation Learning (He et al., 2020, CVPR 2020 camera-ready)

論文:https://arxiv.org/abs/1911.05722

実装コード:https://github.com/facebookresearch/moco

概要

Contrastive loss の学習の際, キーのディクショナリ及びキーのエンコーダーをMomentumに変化させる事で, メモリ効率よく, 画像の特徴を Unsupervised に学習するための学習手法 (通称MoCo).

MoCoでは, q(クエリ)をディクショナリのキーと照合する事によって学習を進めていく. pretext task(本来のタスクではなく, 画像表現を学習するための建前のタスク) は instance discrimination を採用しているが, MoCo自体の考え方は他の手法にも応用できる. 汎用性が高く, 物体検知やセグメンテーション等の様々なダウンストリームへの事前学習として使用できる.

MoCoでは, q(クエリ)をディクショナリのキーと照合する事によって学習を進めていく. pretext task(本来のタスクではなく, 画像表現を学習するための建前のタスク) は instance discrimination を採用しているが, MoCo自体の考え方は他の手法にも応用できる. 汎用性が高く, 物体検知やセグメンテーション等の様々なダウンストリームへの事前学習として使用できる.

手法

loss

k+は正例で, τは温度パラメータ. ミニバッチのクエリqに対して, 全キーのディクショナリを参照する事で, 正例とそれ以外の全ての負例について学習する. f_qはそれに応じて更新され, f_kは少しずつ更新される(ここがMomentum. 後述. ).

Momentum contrast

MoCoの論文では, 良い特徴量を入手するためには, ディクショナリは可能な限り大きく, 更新していく中で一貫性が保たれているのが好ましいという仮説を立てている.

このモチベーションの下での, MoCoの工夫点が以下

ディクショナリを配列として扱う:新規データにたいする対比データとして, 過去データからなるキューを利用する. 過去データの特徴量はストックしておき, 新規データにみ現在の特徴抽出機を適用・更新することで, 計算量を対比データのサイズにあまり依存しないようにしている.

Momentum update:クエリのエンコーダーをコピーする手法は, 性能が悪いとされていたが, それはクエリとキーの両方のパラメータ更新が急激に為されるからだという仮定のもと, 勾配の更新をmomentumに行う. mを大きくし(0.9とか), 更新をゆっくりにするのが良いらしい.

エンコーダーは ResNet で, 最終層が128次元の球面エンベッディング. (Zhirong Wu et al., Unsupervised Feature Learning via Non-Parametric Instance Discrimination, CVPR, 2018)

分散学習時に安易にBNを適用すると, キー側に含まれるクエリーが特定の計算ノードへ局在化することで, ノードごとのBNの統計量の不均衡が顕在化し, これが正常な学習を妨げるので, キーを分散する前にshuffleしてから分散しBNを施すshuffling BNを提案しています.

実験

ImageNet と instagram の画像データを用いて, 様々な検証実験を行っている.

- 事前学習のみでの分類精度に関して, 他の教師なし学習手法と比較. 同じパラメータ数の手法と比較して性能が良い事に加え, 様々なタスクに使える汎用性の高さや, あとで述べる MoCo v2 のように, フレームワークとして精度を上げる事ができるポテンシャルの高さが魅力的です.

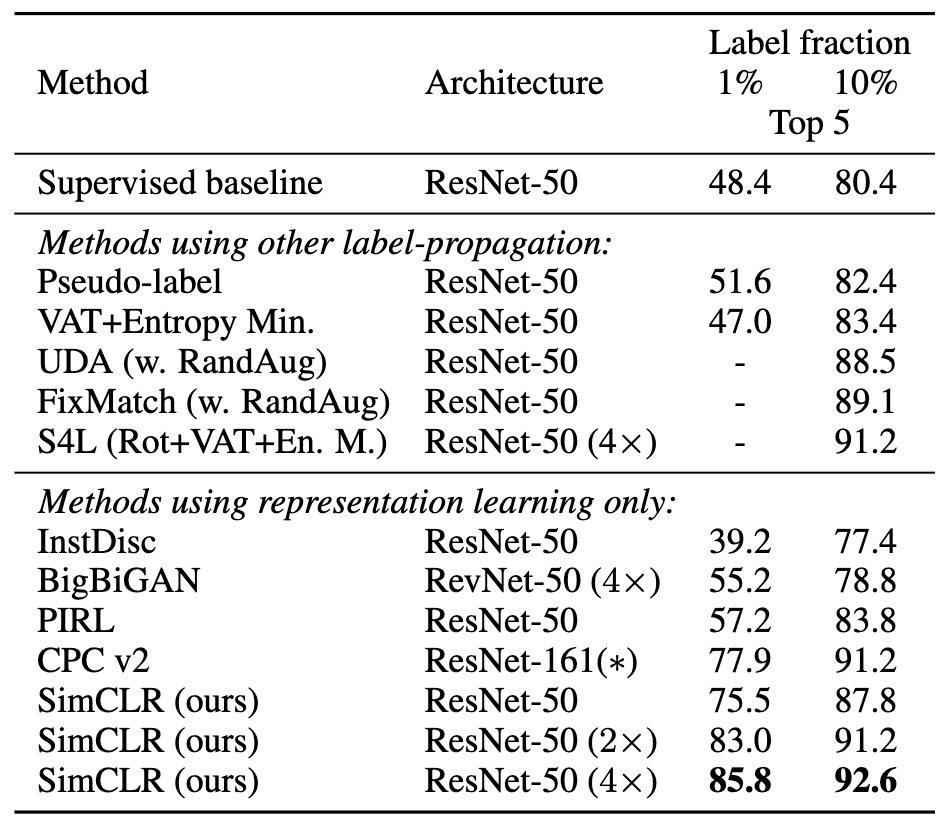

A Simple Framework for Contrastive Learning of Visual Representations (Chen et al., 2020, arXiv)

論文:https://arxiv.org/abs/2002.05709

実装コード:https://github.com/google-research/simclr

概要

シンプルで強力な Contrastive Learning のフレームワーク(通称 simCLR).

MOCOとくらべてキーを保持しないかわりに大きなバッチをとり, その中での(data augmentationを通じた)対比を行う. また, 非線形なprojection headなどの追加構造を加えることで精度向上に成功している.

難点

バッチをかなり大きくする必要があり, そこがどうしてもメモリ的に嬉しくない.

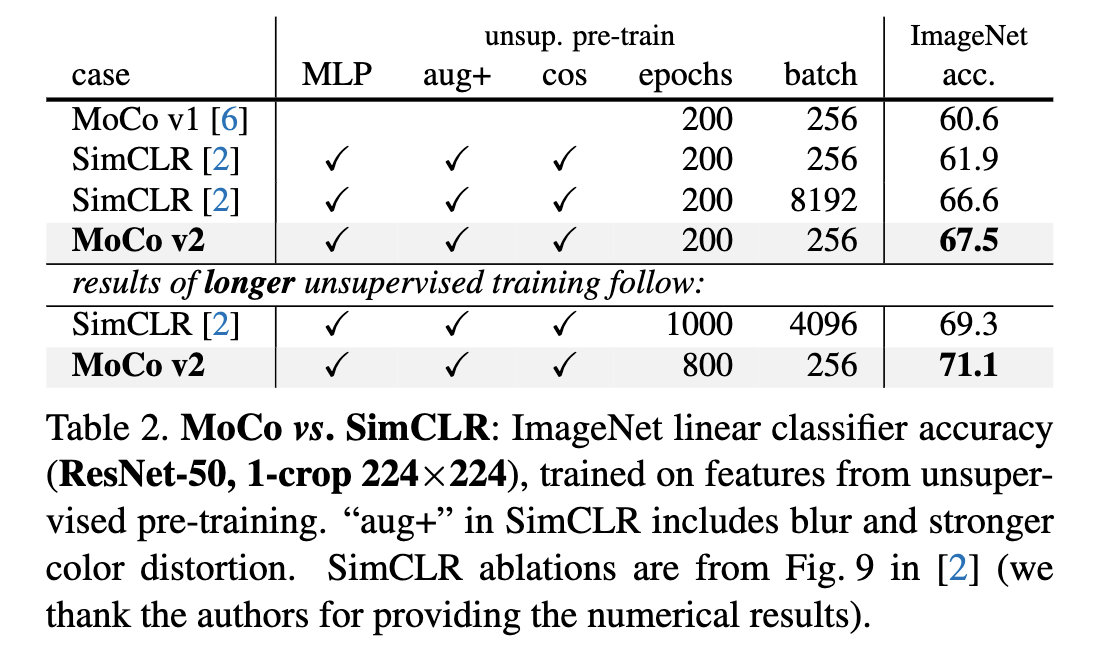

Improved Baselines with Momentum Contrastive Learning(Chen et al., 2020, arXiv)

論文:https://arxiv.org/abs/2003.04297

概要

simCLR はバッチを大きくする必要があり, メモリ的に嬉しくない. そこで MoCo ベースとし, かつ simCLR の「イイとこ取り」をしたフレームワーク MoCo v2 を提案.

MoCo からの差分としては,

- epoch を増やした.

- projection head を採用した.

- より強力な Data Augmentation を採用.

- 損失関数の温度パラメータを再調整.

simCLR との比較 ↓

小まとめ

Contrastive learning は, まだ色々と試行錯誤の余地がありそうで, かなりHotな感じがします. MoCo論文2個は Facebook AI Research からの論文で, simCLR はHinton氏が共著者である事にも注目です.

これらを踏まえ, 画像データに対する Active Learning の使い所として, 教師なし事前学習 と Active Learning を組み合わせることで, 以下のような応用例が考えられます.

5, Active Learning の使い所

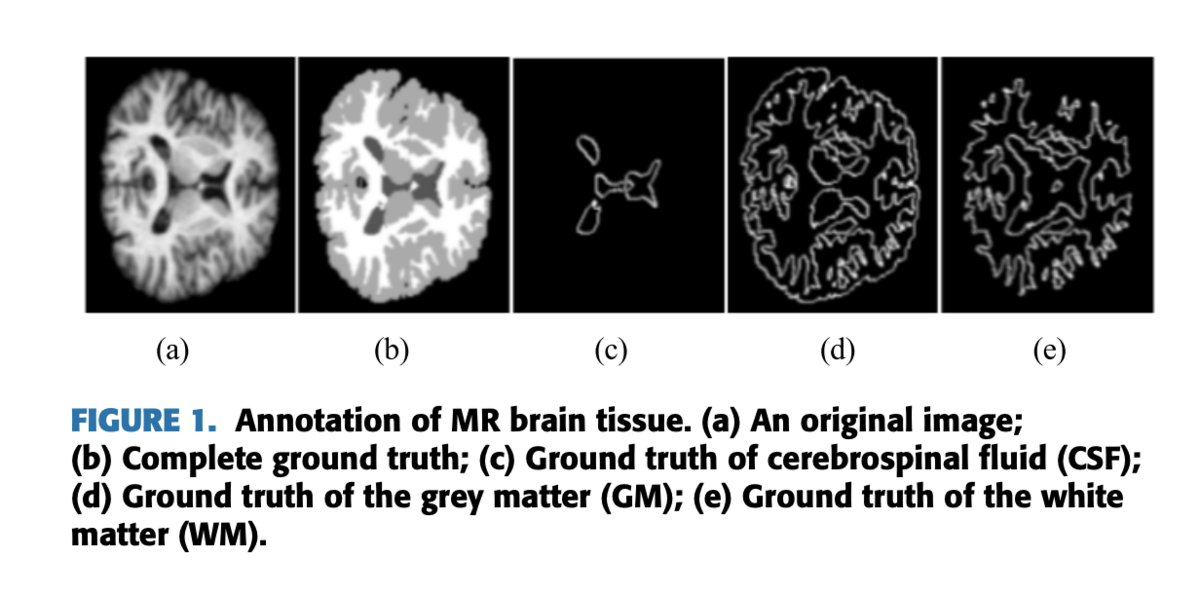

Active Learning と教師なし事前学習を組み合わせて使うことで効果を発揮できそうな領域の例として, 医療画像データのアノテーションが考えられます.

例えば, A New Framework to Reduce Doctor’s Workload for Medical Image Annotation, IEEE, 2019で触れられている上図の例では 1 枚のMR画像から 3 種類の脳組織のアノテーションをします.

その作業は専門医しか行えないのにも関わらず, 1 枚のMR画像あたりに約20時間のアノテーション作業が必要だと述べられています.

お医者さんは世の中で最も忙しい職種の一つであり, このような負荷が高い作業を何日も続けるのは不可能です. なので, アノテーションの量は最小限に抑え, 精度の高いモデルを作成する事が望まれます.

ここで, simCLR の論文では少量のラベルを使用する事で, 大きな精度改善がなされる事が示されています(ただし, タスクはclassification ).

この事から, 医療データのアノテーションのように大量アノテーションが現実的でない場合に, 強力な教師なし学習を用いて, さらにActive Learning も用いる事で, エキスパートへの負担を最低限に減らしつつ実務に用いる事ができるような高精度なモデルを構築することが可能にかもしれないと考えています. (ただし医療分野はプライバシーの問題もあり, 技術面以外にも解決すべき課題があるようです. )

この例に留まらず, 「エキスパート✖️アノテーション」の組み合わせが生じる分野で, 教師なし事前学習 ✖️ Active Learning が有効な場合があるのではないかと考えています. (実験系での応用, 魚の目利き(?), ...)

以上, Active Learning に関する近年の研究動向サーベイ・近年注目の教師なし学習手法の解説・画像分野での Active Learning の応用例の提案 でした.

6, まとめと感想

画像データに関する Active Learning の最近研究の動向・問題意識・活用範囲, 及び contrastive learning の解説を行いました.

「アノテーションを楽にしたい」という全MLエンジニアの願いに応えるべく, Active Learning の研究は今後も一層進んでいくと思います. 今回のサーベイでも, 他のタスクで成果が出ている手法やテクニックを積極的に取り入れた様々な新しい手法があり, 読んでいて面白かったです.

しかしActive Learning手法間の精度競争に終始してしまうと, 取り組み自体は面白くても実務で使えず, 言い方は悪いですが「自己満足」のような結果に見えてしまいます.

なので 事前学習や Data Augmentation のようなテクニックと合わせて効果を検証し, 「これはどのような分野の, どういう場合で使えるのか. 」という具体的なユースケースを考えることが大事で, これは Active Learning に限らず, ML分野全般で言える事なのではないかと思います.

自分も「これは世の中のどういうケースに使えるのか. 自己満足になってないか. 」を一層意識して, これからの研究を行っていきたいです.

また, アノテーションに機械学習を活用することを考えると, Active Learning だけでなく,

- 自動でのアノテーションノイズの検知手法

- ノイズのあるデータからのモデルの学習手法

- よりコスパの良いアノテーション手法

- 限られた予算内で, コスト低(アノテーションの質:低)の大量データ vs コスト高(アノテーションの質:高)の少量データのどちらを用いた場合に, より高い性能のモデルを構築できるかの定量的な評価(とその評価手法)

等, 考えたい事が無数に出てきます. どれも汎用的な最適解を見つけるどころか, そもそも特定の場合への手法すらも未解決な感じです. 機械学習の実務への応用を考える上で, これらの課題の解決は非常に意義のあるものだと思いますので, ここまで読んでくださった物好きの方, 研究テーマにいかがでしょうか?笑

ABEJAでも以前にサーベイや検証がなされているものもあるので, 以下の記事をご参考ください.

- 効率よくアノテーションを行うサーベイ:https://tech-blog.abeja.asia/entry/annotation-survery

- アノテーションノイズのモデル精度への影響:https://tech-blog.abeja.asia/entry/ml-annotation

- ノイズありデータからの学習手法サーベイ:https://tech-blog.abeja.asia/entry/noisy-label-ml-survey

インターンの感想としては, 画像系の論文サーベイをはじめて本格的に行ってみて, 画像系のカンファレンスの論文の数, arXiv で毎日更新される論文の数に圧倒されました.

そして論文の数が多い反面, 全部が全部「良い論文」なわけではなく, 検証が不十分だったり問題設定が簡単すぎる論文もそれなりに見られ, 取捨選択が大切だと感じました. 選球眼を養っていきたいです.

総じて, 専門分野から少し離れた位置でのサーベイは非常に楽しかったです ! 自分の研究分野における発想にも深みが出た気がします(気がしているだけかも).

最後に, ~紹介なんかせず自分がもう一度いきたいのですが本当にお世話になったので正直に書くと~ , ABEJAのインターンは, よくある普通のインターンとは異なり,

- 実務に即した問題設定に対する挑戦

- 格上のメンター(リサーチャー・エンジニア)からの毎日のフィードバック

- 優秀すぎる同期からの刺激

- メンターに留まらず, CEO・COO・コンサルチームの方など, 普通は接する事のできない人間とのディスカッションの機会

- 圧倒的な自由度

など, 「機械学習の研究開発に関わる学生」だけでなく, 全ての「今より成長したい人間」にとって理想の機会が「こんなに良いの?笑」と逆に心配になるくらい盛り沢山です.

通年で募集をしているので, 気になった方はぜひ!

では!

7, References

Andreas Kirsch, Joost van Amersfoort, Yarin Gal, 2019. BatchBALD: Efficient and Diverse Batch Acquisition for Deep Bayesian Active Learning, NIPS

Burr Settles, 2009. Active Learning Literature Survey , Computer Sciences Technical Report 1648

Christoph Mayer, Radu Timofte, 2020. Adversarial Sampling for Active Learning, WACV

Donggeun Yoo, In So Kweon, 2019. Learning Loss for Active Learning, CVPR

Kaiming He, Haoqi Fan, Yuxin Wu, Saining Xie, Ross Girshick, 2019. Momentum Contrast for Unsupervised Visual Representation Learning, arXiv:1911.05722

Oriane Siméoni, Mateusz Budnik, Yannis Avrithis, Guillaume Gravier, 2019. Rethinking deep active learning: Using unlabeled data at model training, arXiv

Samarth Sinha, Sayna Ebrahimi, Trevor Darrell, 2019. Variational Adversarial Active Learning, ICCV

Sudhanshu Mittal, Maxim Tatarchenko, Özgün Çiçek, Thomas Brox, 2019. Parting with illusions about Deep Active Learning, arXiv

Toan Tran, Thanh-Toan Do, Ian Reid, Gustavo Carneiro, 2019. Bayesian Generative Active Deep Learning, ICML

Ting Chen, Simon Kornblith, Mohammad Norouzi, Geoffrey Hinton, 2020. A Simple Framework for Contrastive Learning of Visual Representations, arXiv:2002.05709

Xinlei Chen, Haoqi Fan, Ross Girshick, Kaiming He, 2020. Improved Baselines with Momentum Contrastive Learning, arXiv:2003.04297

Yarin Gal, Riashat Islam, Zoubin Ghahramani, 2017. Deep Bayesian active learning with image data, ICML

YANG DENG, YAO SUN, YONGPEI ZHU, YUE XU, QIANXI YANG, SHUO ZHANG, ZHANYU WANG, JIRANG SUN, WEILING ZHAO, XIAOBO ZHOU, AND KEHONG YUAN, 2019. A New Framework to Reduce Doctor’s Workload for Medical Image Annotation, IEEE